Previsioni meteo: fino a quanti giorni ci si può spingere?

Previsioni meteo: fino a quanti giorni ci si può spingere? E perché si sbaglia?

Fino a quanti giorni può spingersi la previsione del tempo? La domanda è facile, la risposta un po' meno. Prima di tutto dobbiamo capire perché c'è sempre un margine d'errore nelle previsioni meteo, cosa che potete approfondire nella sezione dedicata ai segreti dei modelli numerici. Qui ci basta ricordare alcuni dei tanti motivi, semplificando il più possibile:

Fino a quanti giorni può spingersi la previsione del tempo? La domanda è facile, la risposta un po' meno. Prima di tutto dobbiamo capire perché c'è sempre un margine d'errore nelle previsioni meteo, cosa che potete approfondire nella sezione dedicata ai segreti dei modelli numerici. Qui ci basta ricordare alcuni dei tanti motivi, semplificando il più possibile:

- l'atmosfera è un fluido e come tale è soggetto alle leggi della fluido-dinamica, le quali sono matematicamente rappresentabili con equazioni differenziali alle derivate parziali, il che vuol dire introdurre errori numerici in quanto nei computer tali equazioni possono essere codificate solo alle differenze finite, cioè per "intervalli" e non in modo "continuo", come dovrebbe essere;

- alcuni fenomeni atmosferici non sono rappresentabili con formule e leggi precise, ma solo approssimate (per difficoltà matematiche o scarsa conoscenza dei fenomeni e delle varie interazioni atmosfera/suolo/oceani);

- errori strumentali di misura. Le simulazioni al computer partono dalle cosiddette condizioni iniziali, cioè per prevedere lo stato futuro dell'atmosfera occorre partire da uno stato noto. Ora, sebbene esistano sofisticate tecniche di acquisizione dati (assimilazione) questo stato può essere solo con approssimazione, perché esisteranno sempre errori nelle misurazioni e tali misurazioni non coprono in modo continuo ogni punto dell'atmosfera, in quanto...

- è impossibile rappresentare ogni punto dell'atmosfera, comprese le condizioni iniziali, ma solo alcuni. Per questo si parla di "risoluzione", cioè del "passo" che ha la "griglia" di calcolo con la quale si suddivide l'atmosfera stessa nelle 3 dimensioni (risoluzione orizzontale e verticale). In generale una maggiore risoluzione aiuta il modello a migliorare i calcoli, perché si ha una rappresentazione meno approssimata dell'atmosfera, ma questo non si traduce sempre in una migliore previsione. Infatti aumentando la risoluzione si hanno più dettagli e si tende a "pretendere" una migliore precisione spazio/temporale dei fenomeni. Essendo il modello in teoria ad esempio capace di modellare anche fenomeni più "locali" (come un singolo temporale) si pensa di poterlo considerare in fase previsionale, cosa che non si farebbe col modello a bassa risoluzione. Esempio: con quest'ultimo ci si limiterebbe a dire "probabili temporali sulle zone interne del Centro Italia", mentre con l'altro si è tentati di localizzare meglio magari con un "possibile temporale nella provincia di Arezzo dopo le 17"... capite che anche se il modello mi fornisce questa soluzione, è più facile "azzeccare" quella del modello con meno "pretese"...

- Sempre a proposito di risoluzione, proprio perché i modelli calcolano solo alcuni punti dell'atmosfera, distanti qualche (o tanti...) km, è intrinsecamente impossibile risolvere molti dei fenomeni che si verificano. Ad esempio il calcolo delle precipitazioni: non crederete mica che i modelli possano seguire e calcolare formazione ed evoluzione di ogni singola goccia di pioggia e/o di nube e relative reciproche interazioni e con l'ambiente circostante... Oppure i temporali, il più delle volte circoscritti intorno ad una manciata di km se non meno. Supponiamo di avere un modello con un passo di griglia di 12 km: significa che nelle due direzioni orizzontali abbiamo a disposizione 1 punto di calcolo ogni 12 km. Come pensate si possano descrivere nubi e fenomeni di dimensioni inferiori? E anche per dimensioni superiori... quanti punti di calcolo abbiamo? Pochi, molto pochi. Per questo esistono tecniche (come la parametrizzazione convettiva) che solo indirettamente (e molto approssimativamente) possono descrivere fenomeni di questo tipo. Capite che descrivere nubi e piogge è molto più difficile del semplice calcolo della temperatura. Per dire. Ah, naturalmente c'è anche la risoluzione verticale: l'atmosfera viene divisa in più "strati", più o meno distanti tra loro. Quindi alla fine la griglia di calcolo è tridimensionale;

- impossibile rappresentare in modo esatto l'orografia (sempre discorso sulla risoluzione). Anche se fosse, impossibile sapere se un certo terreno viene arato o resta erboso (il che ad esempio può fare la differenza sulla stima delle temperature in quel luogo o se ci sarà l'innesco di una termica che potrà o meno svilupparsi come temporale);

- molte delle equazioni/formule, ecc., non sono lineari, perciò tutti questi errori si propagano esponenzialmente col procedere delle ore/giorni di previsione. Capiamo con un esempio semplice: un errore doppio oggi, non si traduce in un errore doppio domani, ma magari quadruplo o peggio...

Ora capite (alcuni!) dei motivi per cui anche se, in teoria, la previsione del tempo sarebbe un fatto deterministico (noto lo stato attuale dell'atmosfera posso calcolare quello futuro) in pratica ciò non è possibile e dobbiamo per forza interpretare le previsioni in senso probabilistico, capire cioè quale sembra essere l'evoluzione più probabile, che è poi quella che viene comunicata agli utenti!

Come possiamo quantificare tale probabilità? In generale, a parità di parametro selezionato (pioggia, temperatura...), la probabilità di errore aumenta con l'intervallo temporale prescelto. Si va da più del 90% nelle 24 ore, a meno del 60% oltre i 7-10 giorni. Ma tutto dipende, come dicevamo, anche da ciò che intendiamo prevedere (un temporale può essere difficile da prevedere anche a poche ore, la neve è più difficile da prevedere rispetto alla pioggia...) e dagli scenari meteorologici in atto o previsti (l'aria calda è più facile da prevedere rispetto a quella fredda, un anticiclone potente difficile da smuovere è più facile da prevedere e così via...)

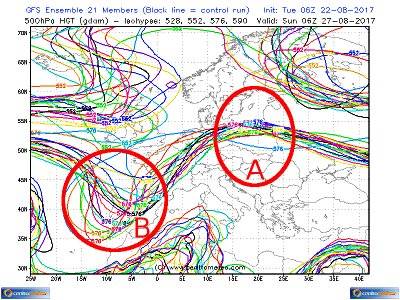

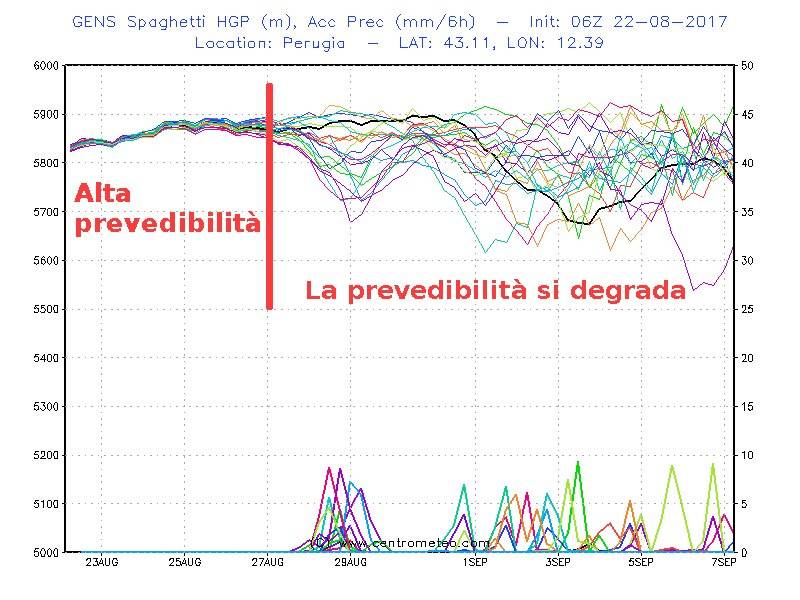

Come possiamo capire se quello che ci dice il modello è più o meno "affidabile"? E' importante l'esperienza del previsore, specialmente per eventuali considerazioni locali che tengano conto di specifiche caratteristiche micro-climatiche e considerazioni sulla conoscenza di errori tipici/sistematici dei modelli. Non possiamo certo qui affrontare nei dettagli il complicato approccio statistico alla Meteorologia, ma ci limiteremo a fornire qualche aspetto che possa però aiutare nella pratica anche il neofita quando si tratta di sbilanciarsi o meno nell'evoluzione meteorologica nelle sue linee generali, che è comunque il punto di partenza, prima di addentrarsi nei dettagli di una previsione. Già, perché la prevedibilità dell'atmosfera non è sempre la stessa, né oggi rispetto a ieri, né oggi in diverse zone del globo. Dunque prima di ogni altra considerazione occorre capire fino a quale giorno sulla nostra zona di interesse (per esempio l'Italia) l'atmosfera mostra una certa prevedibilità, aumentando dunque le possibilità di vedere, attraverso i modelli, l'evoluzione futura più probabile. Lo strumento per far questo è la tecnica Ensemble, le cui mappe sono disponibili sottoforma di spaghetti (sì, spaghetti... basta vederli e capirete perché!). Possiamo scegliere un parametro specifico da monitorare su un punto specifico, come nelle carte spaghetti del modello americano GFS, oppure gli stessi parametri, ma su un'area più vasta, come nelle mappe GFS che trovate tra i modelli globali. Di cosa si tratta? A più bassa risoluzione (per ragioni di potenza di calcolo a disposizione) si fa girare più volte il modello partendo dagli stessi dati iniziali, ma deliberatamente (e opportunamente) modificati, proprio per vedere che "derive" il modello stesso tende ad avere.

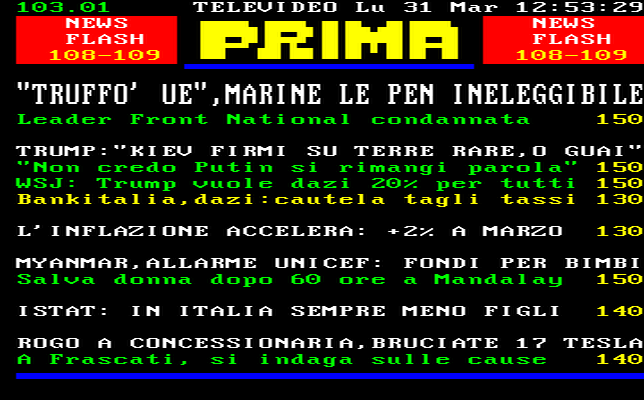

La mappa riportata a sinistra mostra il comparto europeo, usando alcune isoipse di riferimento relative all'altezza geopotenziale di 500hPa calcolate a +120 ore, quindi a 5 giorni. Concentriamoci sulla 5760 metri. Ogni colore è un run e quello in nero è il cosiddetto run di controllo, cioè quello con i dati iniziali non modificati. Possiamo vedere come in prossimità della Penisola Iberica già a 5 giorni le isoipse differiscono moltissimo (zona cerchiata B) mentre in prossimità della Polonia tutti i run, eccetto uno, mostrano con "insistenza" il formarsi di un promontorio anticiclonico (zona cerchiata A). Possiamo dire che nella zona A abbiamo una notevole probabilità che la situazione si verifichi (modello molto affidabile) mentre nella zona B potremo avere una saccatura molto pronunciata oppure quasi inesistente, con parecchie "variazioni" sul tema, il che fa una grande differenza sulle sorti meteorologiche di quella zona (modello poco affidabile).

|  |

Allo scopo di ottenere ulteriori conferme (o più o meno parziali smentite) è possibile aggiungere alle informazioni ottenute sopra:

1) il run deteriministico ad alta risoluzione dello stesso modello (diverso dal run di controllo);

2) il run di altri modelli (specialmente ECMWF, cioè il modello europeo, il più performante di tutti, in generale);

3) i run dello stesso modello (anche Ensemble) ma per le corse successive: se con i nuovi dati le nuove corse modellistiche tendono a confermare un certo risultato allora la stima si fa più affidabile (più probabile). GFS fornisce corse ogni 6 ore, anche Ensemble.

Noi nelle nostre previsioni testuali e nelle nostre comunicazioni agli utenti preferiamo in genere sbilanciarci solo quando tendono ad allinearsi almeno tutti e 3 i punti precedenti, salvo rare eccezioni per motivi particolari (anche didattici). Infatti, finché non si ha a disposizione una probabilità maggiore del lancio di una monetina, che senso ha sbilanciarsi? Se non per fare post acchiappa-click...?